關於強化學習的專業插圖

多臂老虎機簡介

多臂老虎機簡介

多臂老虎機(Multi-Armed Bandit, MAB)問題是強化學習中的經典框架,最早源自賭場中玩家面對多台吃角子老虎機時的決策難題。在2025年的今天,這個問題不僅是學術研究的熱點,更廣泛應用於線上廣告投放、醫療試驗、推薦系統等數據驅動領域。簡單來說,它模擬了一個情境:你面前有數台老虎機(或稱多臂賭博機),每台機器的獎勵概率分佈不同,但你不知道哪一台的期望獎勵最高。你的目標是透過一次次拉動搖臂(選擇行動),在有限的嘗試次數內最大化總收益,這就涉及著名的探索-利用權衡(Exploration-Exploitation Tradeoff)。

多臂老虎機的核心在於如何平衡探索(嘗試新選項以收集資訊)和利用(選擇當前已知的最佳選項)。舉例來說,假設某電商平台用UCB1演算法(上置信界算法)來測試不同廣告版位的點擊率。若過度「利用」當前表現最好的版位,可能錯失其他潛在高收益選項;但若過度「探索」新版位,又會浪費資源在低效選擇上。這種勘探-開發兩難的動態調整,正是解決多臂老虎機問題的關鍵。

- 貪婪算法(Greedy Algorithm):

最直觀的方法是每次都選擇當前獎勵分佈估計值最高的搖臂。但這種策略容易陷入局部最優,例如若某搖臂初期回報高但後期變差,系統可能無法及時發現更佳選項。 - 湯普森採樣(Thompson Sampling):

這是一種基於伯努利分佈的機率方法,透過對每個搖臂的獎勵概率進行貝葉斯更新,隨機抽樣後選擇最高值的搖臂。2025年許多推薦系統採用此方法,因其能有效處理不確定性並降低累積懊悔(Regret)。 UCB1 Algorithm:

透過計算上置信界來平衡探索與利用,公式中結合平均獎勵和探索項(如嘗試次數的倒數)。例如,若A搖臂平均獎勵為0.5、嘗試次數少,其UCB值可能高於B搖臂(獎勵0.6但已多次嘗試),促使系統優先探索A。對抗式多臂賭博機(Adversarial Bandits):

適用於獎勵概率可能被惡意操控的情境,如網路安全中的攻擊檢測。- 情境式吃角子老虎機(Contextual Bandits):

結合特徵資訊(如用戶畫像)來動態調整策略,2025年常見於個性化醫療方案推薦。 - 吉廷斯指數(Gittins Index):

在無限時間範圍下計算各搖臂的動態分配指數,適合長期決策場景,如資源管理。

假設某串流平台使用湯普森採樣來優化影片推薦。系統會為每部影片建立一個概率模型,初期隨機展示新片(探索),隨著用戶反饋數據累積,逐漸增加高點擊率影片的曝光(利用)。這種方法相較於傳統A/B測試,能更快收斂到最優策略,並減少用戶體驗的波動。

在機器學習領域,多臂老虎機問題也常被視為簡化版的強化學習,因為它省略了狀態轉移的複雜性,專注於策略最佳化。2025年的研究顯示,結合蒙特卡洛採樣與深度學習的混合模型,能進一步提升解決高維度老虎機問題的效率。

關於多臂老虎機的專業插圖

問題定義與形式化

問題定義與形式化

在強化學習領域中,多臂老虎機問題(Multi-Armed Bandit Problem, MAB)是一個經典的探索-利用權衡(Exploration-Exploitation Tradeoff)框架,用來模擬決策者在面對多個選擇時的優化挑戰。這個問題的命名源自賭場中的多臂賭博機(或稱吃角子老虎機),玩家每次拉動拉桿(即選擇一個「臂」)會獲得隨機獎勵,目標是透過多次嘗試最大化累積獎勵。

從數學角度來看,多臂老虎機問題的形式化通常包含以下要素:

1. K個臂(選項):每個臂對應一個獨立的獎勵分佈(例如伯努利分佈),其期望獎勵(Expected Reward)未知。

2. 時間步長(T):在有限或無限的時間範圍內,決策者需逐步選擇臂並觀察回饋。

3. 累積懊悔(Cumulative Regret):衡量策略表現的關鍵指標,定義為「最優策略的總獎勵」減去「實際策略的總獎勵」。懊悔越小,策略越接近最佳化。

舉個具體例子:假設你在2025年經營一個電商平台,首頁有5個推薦商品欄位(即5個「臂」),每個欄位的點擊轉換率(獎勵概率)未知。你的目標是透過數據驅動的動態調整,找到轉換率最高的商品組合,這就是典型的多臂吃角子老虎機測試應用。

為了解決這個問題,學術界和業界發展出多種策略,例如:

- 貪婪算法(Greedy Algorithm):始終選擇當前估計獎勵最高的臂,但可能陷入局部最優(缺乏探索)。

- UCB1 Algorithm(上置信界算法):平衡探索與利用,根據置信區間動態調整選擇,確保長期最優性。

- 湯普森採樣(Thompson Sampling):基於概率論的貝葉斯方法,透過抽樣決定行動,特別適合非靜態環境。

進階的變體還包括對抗式多臂賭博機(Adversarial Bandits),其中獎勵分佈可能被惡意調整,或是情境式吃角子老虎機(Contextual Bandits),結合特徵資訊(如用戶畫像)來個人化決策。這些擴展讓MAB問題在現代機器學習應用中更具彈性,例如廣告投放、醫療試驗或自動化交易。

在實務中,選擇哪種策略取決於問題特性:

- 若獎勵分佈穩定且已知(如伯努利分佈),吉廷斯指數(Gittins Index)可提供理論最優解。

- 若需快速收斂且計算資源有限,UCB1演算法因其確定性邊界而受青睞。

- 若環境存在不確定性(如用戶偏好變化),湯普森採樣的隨機性更能適應動態場景。

總之,多臂老虎機問題的形式化不僅是理論課題,更是實際系統中策略最佳化的核心工具。透過理解其數學基礎與應用場景,開發者能更有效地設計數據驅動的決策流程,降低累積懊悔並提升商業價值。

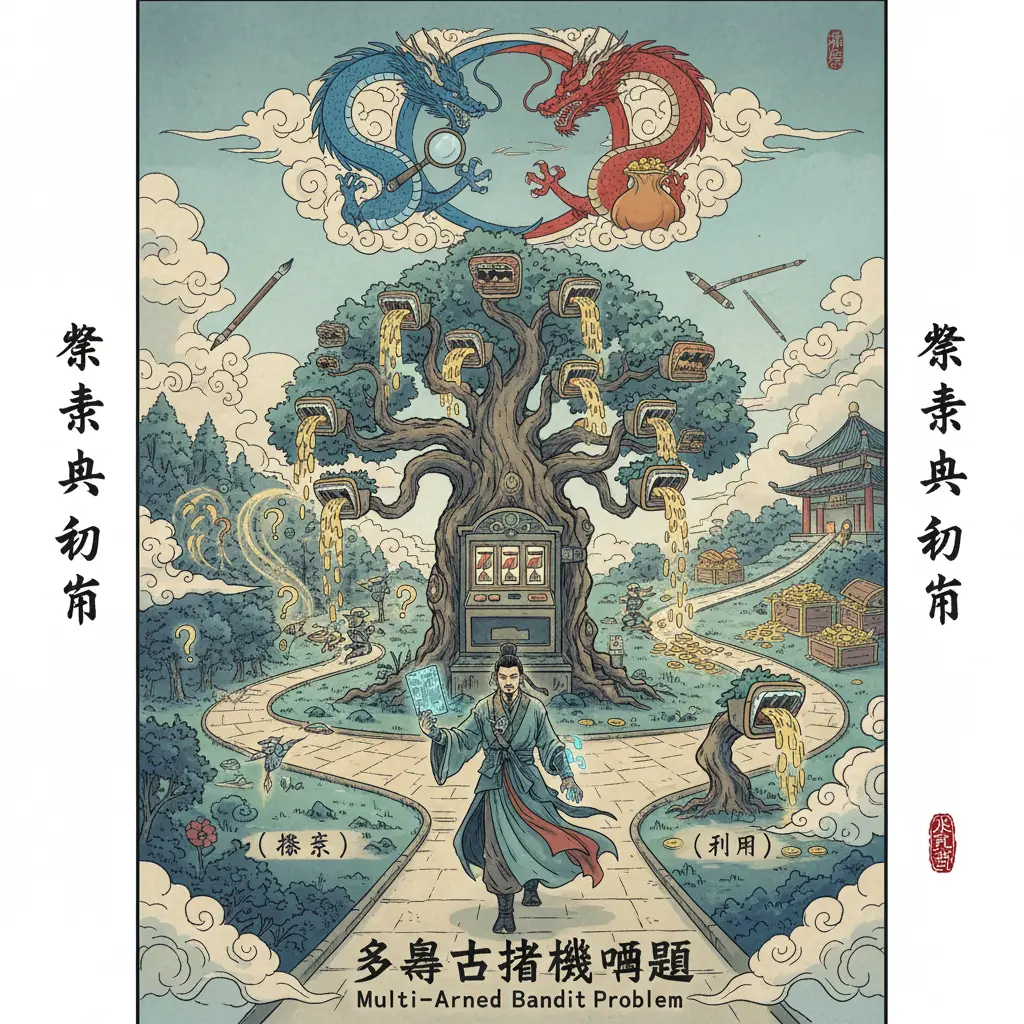

關於多臂賭博機的專業插圖

累積懊悔解析

在強化學習領域中,累積懊悔(Cumulative Regret)是評估多臂老虎機問題解決方案的核心指標之一。簡單來說,懊悔指的是「因為沒有選擇最佳選項而損失的潛在獎勵」。舉例來說,假設你面前有3台吃角子老虎機,每台的獎勵概率分佈不同,如果你一直選擇次佳的機器,累積下來的獎勵差距就是你的累積懊悔。2025年的最新研究顯示,降低累積懊悔的關鍵在於如何有效平衡探索與利用——也就是何時該嘗試新選項(探索)、何時該堅持已知的高回報選項(利用)。

- 數學定義:累積懊悔的公式通常寫為 ( R_T = T \cdot \mu^ - \sum_{t=1}^T \mu_{a_t} ),其中 ( \mu^ ) 是最佳機器的期望獎勵,( \mu_{a_t} ) 是第 ( t ) 次選擇的機器獎勵。這公式直接反映了策略的「效率損失」。

實際影響:在電商推薦系統中,累積懊悔過高可能意味著平台錯失了將高轉化率商品曝光給用戶的機會,直接影響營收。

UCB1演算法(上置信界算法):

透過計算「獎勵平均值 + 探索項」來選擇動作,其中探索項會隨時間減少。例如,某機器的平均獎勵是0.5,但它的探索項可能因為嘗試次數少而較高,促使系統優先測試它。2025年的改良版UCB1已能更動態調整探索權重,尤其適合對抗式多臂賭博機這類非平穩環境。- 湯普森採樣:

基於伯努利分佈的貝葉斯方法,直接對每台機器的獎勵概率進行採樣,選擇最高採樣值的機器。這種方法在情境式吃角子老虎機中表現出色,因為它能整合上下文資訊(如用戶畫像)。 貪婪算法的改進:

傳統貪婪算法只利用已知最佳選項,但加入ε概率的隨機探索(ε-greedy)能顯著降低長期懊悔。實務上,動態調整ε值(如隨時間衰減)是2025年的常見優化手法。非平穩環境:許多真實場景(如股市交易)的獎勵分佈會隨時間變化,此時需引入滑動窗口或指數加權來更新統計量。

- 高維情境:當機器選擇還需考慮外部變數(如用戶地理位置),傳統方法可能失效。最新研究傾向結合深度學習來建模複雜關係。

- 懊悔邊界分析:理論上,UCB1的累積懊悔成長速度是 ( O(\log T) ),但實作時需注意隱性假設(如獎勵分佈的次高斯性)。

實例說明:假設一個線上廣告系統用多臂吃角子老虎機測試分配版位,A版位點擊率5%、B版位4.8%。若前1000次展示全選A,累積懊悔是 ( 1000 \times 0.05 - 1000 \times 0.05 = 0 );但若誤判B為最佳而展示800次,懊悔就變成 ( 1000 \times 0.05 - (200 \times 0.05 + 800 \times 0.048) = 16 ),相當於損失了16次潛在點擊。

- 吉廷斯指數:適用於無限時間範疇的問題,計算每台機器的「繼續使用價值」,但計算成本較高,2025年多改用近似方法。

- 蒙特卡洛採樣:當理論分析困難時,可透過模擬比較不同策略的懊悔分佈,尤其適合概率論模型複雜的場景。

- 對抗式環境的魯棒性:若對手會主動干擾獎勵(如競爭對手調整定價),需引入EXP3等對抗性學習算法。

最後要注意,累積懊悔的解析必須配合領域知識。例如在醫療試驗中,懊悔可能代表患者接受次佳治療的風險,此時需更保守的探索策略。2025年的工具(如開源庫BanditLib)已能自動化懊悔追蹤與策略調參,但人工解讀結果仍不可或缺。

關於多臂吃角子老虎機測試的專業插圖

期望獎勵估計法

在強化學習領域中,期望獎勵估計法是解決多臂老虎機問題的核心技術之一。簡單來說,這個方法就是透過統計和概率論來預測每台「吃角子老虎機」(也就是多臂賭博機)的潛在報酬率,幫助我們在探索與利用權衡中做出更聰明的選擇。舉個例子,假設你有三台老虎機,每台的獎勵概率分佈都不一樣,有的可能贏錢機率高但獎金少(比如伯努利分佈中成功概率0.7但獎金只有10元),有的則相反(概率0.3但獎金50元)。這時候,期望獎勵估計法就能幫你算出哪台機器長期下來最划算,而不是瞎猜或一直換機器。

具體怎麼做呢?最常見的方法是透過貪婪算法或UCB1演算法(上置信界算法)來動態更新每台機器的期望值。以UCB1為例,它不僅考慮歷史平均報酬,還會加入一個「不確定性」的調整項,確保你不會因為短期運氣差就放棄潛力股。比如說,A機器玩了10次,平均每次賺20元;B機器只玩2次,平均15元。單純看平均值的話,A好像比較好,但B因為數據少,上置信界算法會給它更高的「探索價值」,避免你錯過可能更好的選擇。這種平衡勘探-開發兩難的技巧,正是多臂吃角子老虎機測試的關鍵。

進階一點的作法還會用到湯普森採樣或吉廷斯指數。湯普森採樣是透過蒙特卡洛採樣模擬每台機器的獎勵分佈,直接從概率中隨機抽取可能的結果,再根據這些模擬數據決定下一步。這種方法特別適合對抗式多臂賭博機或情境式吃角子老虎機,因為它能快速適應環境變化。舉例來說,如果某台機器突然被賭場調整了中獎率,傳統的貪婪算法可能會卡在舊數據裡,但湯普森採樣能透過動態更新獎勵分佈來即時反應。

實務上,這些方法的效能可以用累積懊悔(Regret)來評估,也就是你的策略和「理論最佳策略」之間的差距。例如,假設上帝告訴你B機器其實最賺,但你因為前期探索不足,一直玩A機器,那你的累積懊悔就是少賺的那些錢。好的期望獎勵估計法會盡量壓低這個數字,而這通常需要結合數據驅動的調整和策略最佳化技巧。比如在電商領域,你可以把「老虎機」換成「不同的廣告版位」,用同樣的方法找出哪個版位的點擊率(CTR)最高,這就是機器學習在商業中的經典應用。

最後要注意的是,期望獎勵估計法的選擇必須配合問題特性。如果是靜態環境(例如固定的老虎機中獎率),UCB1演算法或吉廷斯指數這類基於動態分配指數的方法可能就夠了;但如果是動態環境(例如對手會調整規則),湯普森採樣或基於蒙特卡洛採樣的模型會更靈活。總之,理解背後的概率論原理,並根據實際場景調整探索與利用的比例,才是搞定吃角子老虎機問題的不二法門。

關於探索-利用權衡的專業插圖

探索與利用平衡術

在強化學習領域中,探索與利用權衡(Exploration-Exploitation Tradeoff)是解決多臂老虎機問題的核心挑戰。簡單來說,當你面對多台吃角子老虎機(每台機器的獎勵概率分佈不同),該如何分配有限的拉桿次數,才能最大化總收益?這就是著名的勘探-開發兩難。舉個生活化的例子:假設你常去的餐廳有5道招牌菜,但預算只夠點3道。你是該冒險嘗試新菜(探索),還是穩扎穩打選擇已知好吃的菜(利用)?這種決策困境正是多臂賭博機問題的縮影。

要破解這個難題,學界和業界發展出多種最優策略,其中最具代表性的包括: - 貪婪算法(Greedy Algorithm):永遠選擇當前期望獎勵最高的選項,但可能陷入局部最優。 - UCB1演算法(上置信界算法):透過數學公式平衡探索與利用,優先選擇「潛在價值高」或「嘗試次數少」的選項。 - 湯普森採樣:基於伯努利分佈進行蒙特卡洛採樣,動態更新對每台機器的信心程度。 - 吉廷斯指數:適用於無限時間軸的理論解,但計算複雜度高。

以UCB1 algorithm為例,它會為每個選項計算一個「分數」,公式為:分數 = 平均獎勵 + √(2*ln(總嘗試次數)/該選項嘗試次數)

前半段反映利用(已知表現),後半段強化探索(減少未充分測試的選項)。2025年的最新研究顯示,在對抗式多臂賭博機情境中,UCB1的變體(如UCB-Tuned)能有效降低累積懊悔(Regret),尤其當獎勵分佈隨時間變化時。

實務上,選擇策略需考慮數據驅動的實際條件: 1. 資源限制:若預算極少(如只能拉桿10次),傾向高探索;若資源充足,可逐步轉向利用。 2. 動態環境:像是情境式吃角子老虎機,獎勵概率會隨外部因素變動,需持續監測並重新評估。 3. 風險承受度:醫療實驗等領域可能優先選擇湯普森採樣,因其對不確定性的建模更細膩。

進階技巧:結合概率論與機器學習,現代解法已能處理更複雜的變體。例如: - 用動態分配指數調整探索權重,適應非平穩(Non-stationary)環境。 - 在廣告投放場景中,A/B測試框架本質就是一種多臂吃角子老虎機測試,企業會根據點擊率實時調整UCB1參數。

最後要注意,策略最佳化不是一勞永逸。2025年一篇針對電商推薦系統的研究指出,當用戶行為模式突變(如節慶促銷期間),純依賴歷史數據的貪婪算法表現會顯著下滑,此時必須臨時提高探索比例,才能捕捉新的熱門商品趨勢。這正是為什麼理解探索與利用的本質,遠比套用固定公式更重要。

關於探索與利用的專業插圖

ϵ-貪心算法實戰

在強化學習領域中,ϵ-貪心算法(Epsilon-Greedy Algorithm)是解決多臂老虎機問題最直觀且廣泛應用的策略之一,特別適合初學者理解探索與利用權衡的核心概念。這個算法的核心思想很簡單:每次選擇動作時,以 1-ϵ 的概率選擇當前期望獎勵最高的「手臂」(即貪婪選擇),並以 ϵ 的概率隨機探索其他選項。舉例來說,若設定 ϵ=0.1,代表有10%的機會會嘗試非最佳選項,避免陷入局部最優解。這種方法在數據驅動的場景中尤其實用,例如電商平台的推薦系統,系統需要平衡「推廣熱門商品」與「測試冷門商品潛力」之間的矛盾。

實務上,ϵ-貪心算法的效能高度依賴 ϵ值 的設定。若 ϵ 過大(如0.5),系統會過度探索,導致累積懊悔(累積懊悔)增加;反之,若 ϵ 過小(如0.01),可能錯失潛在的高報酬機會。2025年的最新實踐中,常見的改進方式是採用動態調整ϵ值,例如隨時間衰減(ϵ=1/t)或根據獎勵分佈的穩定性調整。例如,在情境式吃角子老虎機中,若檢測到用戶行為變化(如節慶期間偏好轉移),可暫時提高 ϵ 以加速重新探索。此外,與UCB1演算法或湯普森採樣相比,ϵ-貪心雖然理論收斂速度較慢,但實現簡單且計算成本低,適合即時性要求高的場景。

以下是一個具體的實戰案例:假設你經營一個線上廣告平台,需在5個廣告版位(多臂賭博機)中分配預算。每個版位的點擊率(伯努利分佈)未知,但歷史數據顯示版位A的平均點擊率為3%。使用 ϵ=0.2 的貪心策略時,80%的時間會選擇版位A,20%的時間隨機測試其他版位。經過一週後,若發現版位D的點擊率突然提升至5%,系統會因探索機制而捕捉到這一變化,並逐步調整貪婪選擇。這種動態平衡正是策略最佳化的關鍵。

進階應用中,ϵ-貪心可結合概率論進行改良。例如,對每個手臂的獎勵概率分佈建模後,可根據信心水準調整 ϵ。若某手臂的獎勵變異數極低(表示估計可靠),可降低其探索概率;反之,對高不確定性的手臂增加探索。這種方法在對抗式多臂賭博機中尤其有效,因為對手可能刻意改變獎勵規則。最後須注意,ϵ-貪心默認所有探索機會均等,但實際場景中,可根據業務需求加權隨機探索(如優先測試成本較低的選項),進一步優化最優策略的收斂速度。

關於湯普森採樣的專業插圖

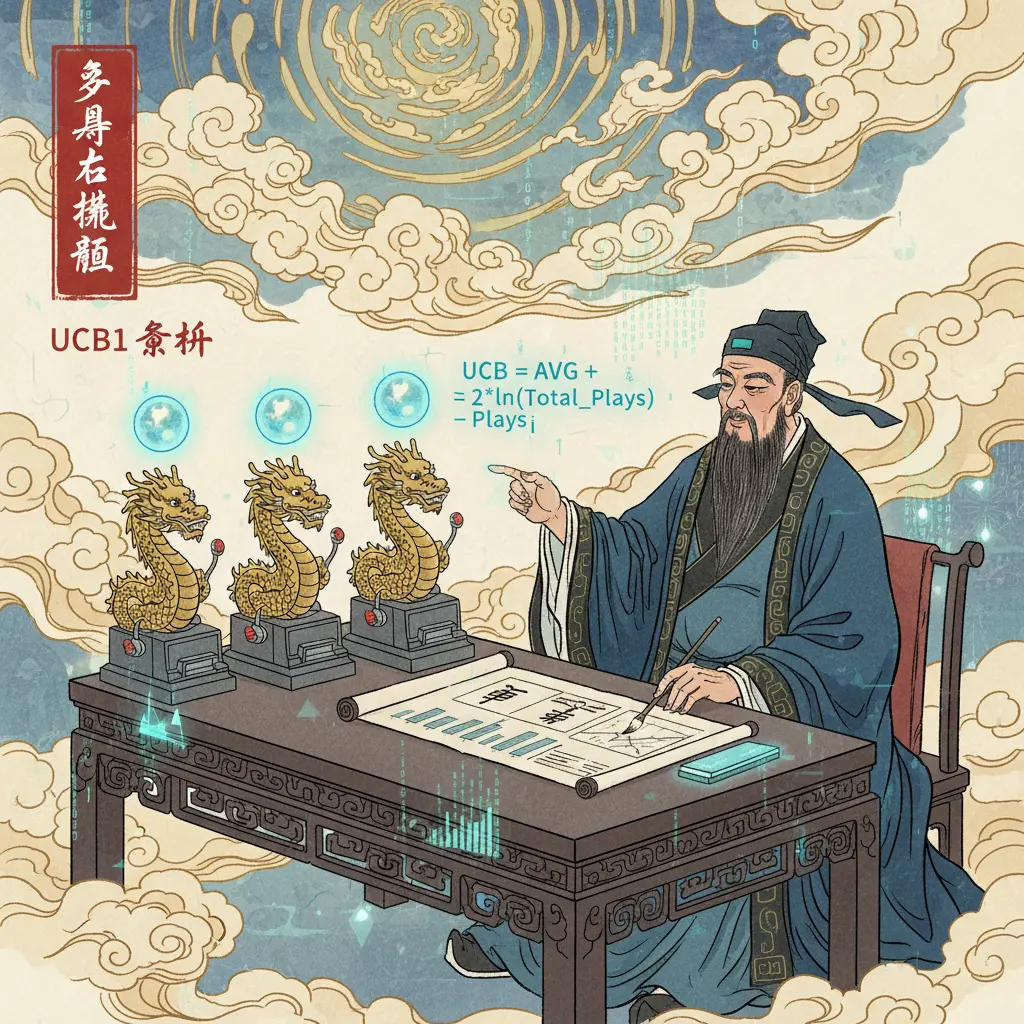

UCB算法深度剖析

UCB算法深度剖析

在強化學習領域中,UCB1 algorithm(上置信界算法)被廣泛應用於解決多臂老虎機問題,尤其是面對探索-利用權衡的挑戰時。UCB算法的核心思想是透過數學公式動態平衡探索與利用,確保在有限的嘗試次數內最大化累積獎勵。具體來說,UCB1會為每個「手臂」(選項)計算一個「信心上限」,這個上限結合了該手臂的期望獎勵和「未探索程度」的懲罰項。公式如下:

UCB值 = 平均獎勵 + √(2 * ln(總嘗試次數) / 該手臂嘗試次數)

這個公式的巧妙之處在於:

1. 前半部分(平均獎勵):反映當前已知的獎勵概率分佈,偏向選擇過去表現好的手臂(利用)。

2. 後半部分(懲罰項):隨著總嘗試次數增加,未充分探索的手臂會被賦予更高的值(探索)。

舉個實際例子,假設你在多臂吃角子老虎機測試中面對3台機器,UCB1會優先選擇「平均獎勵高」或「嘗試次數少」的機器。例如:

- 機器A:玩了10次,平均獎勵50元。

- 機器B:玩了2次,平均獎勵80元。

- 機器C:玩了5次,平均獎勵30元。

即使機器A的獎勵較穩定,UCB1可能因機器B的「高潛力」而選擇它,避免陷入貪婪算法的局部最優陷阱。

UCB的變體與進階應用

UCB1假設獎勵分佈是伯努利分佈(即0或1的二元結果),但現實中獎勵可能是連續的。因此,進階版本如UCB-Tuned或UCB-Normal被提出來適應不同場景:

- UCB-Tuned:加入變異數調整,更適合動態環境。

- UCB-Normal:假設獎勵服從常態分佈,適用於金融或醫療等連續數據領域。

與其他方法(如湯普森採樣或吉廷斯指數)相比,UCB的優勢在於:

理論保證:UCB1的累積懊悔(Regret)有嚴格的上界,確保長期表現接近最優。

無需預設分佈:湯普森採樣需假設先驗分佈,而UCB僅依賴觀測數據,更適合數據驅動的場景。

實務建議與常見陷阱

1. 冷啟動問題:初期數據不足時,UCB可能過度探索。解決方法是結合蒙特卡洛採樣預熱。

2. 非平穩環境:若獎勵概率分佈隨時間變化(如對抗式多臂賭博機),需定期重置UCB的計數器。

3. 計算成本:UCB需即時更新每個手臂的統計量,在情境式吃角子老虎機(Contextual Bandit)中可能需優化數據結構。

最後,UCB雖是解決勘探-開發兩難的強力工具,但選擇算法時仍需考量問題特性。例如:

- 若需快速收斂:UCB1或貪婪算法(ε-Greedy)更直接。

- 若獎勵波動大:湯普森採樣的貝葉斯框架可能更穩健。

透過深入理解UCB的數學本質與實作細節,你可以在多臂賭博機問題中更有效地進行策略最佳化,無論是廣告投放、醫療試驗或遊戲AI設計,都能找到最優策略的平衡點。

關於吉廷斯指數的專業插圖

湯普森採樣全攻略

湯普森採樣全攻略:用概率論破解探索與利用的兩難

在強化學習領域中,湯普森採樣(Thompson Sampling)被公認為解決多臂老虎機問題的頂尖策略之一,尤其擅長處理探索-利用權衡(Exploration-Exploitation Tradeoff)的難題。與UCB1 algorithm這類基於確定性規則的方法不同,湯普森採樣的核心是透過伯努利分佈(Bernoulli Distribution)模擬每台多臂賭博機的獎勵概率,再根據採樣結果動態調整選擇策略。舉例來說,假設你面對3台吃角子老虎機問題,傳統的貪婪算法可能因為過早鎖定高獎勵選項而忽略潛在更好的選擇,但湯普森採樣會持續更新每台機器的獎勵概率分佈,並隨機抽取這些分佈的值來決定下一次拉桿的目標,完美平衡勘探-開發兩難。

實作步驟解析

1. 初始化分佈:為每台老虎機設定一個Beta分佈(伯努利分佈的共軛先驗),假設初始參數α=1、β=1(代表無先驗知識)。

2. 採樣與選擇:每次決策時,從每台機器的Beta分佈中隨機抽取一個值,選擇抽到最高值的機器拉桿。

3. 更新分佈:根據實際獲得的獎勵(成功則α+1,失敗則β+1)動態調整分佈參數,逐步逼近真實期望獎勵。

這種方法的優勢在於:

- 數據驅動:隨著互動次數增加,分佈會越來越準確,減少累積懊悔(Cumulative Regret)。

- 適應性強:即使是對抗式多臂賭博機或非平穩環境(如獎勵概率隨時間變化),也能透過調整分佈參數快速反應。

- 計算高效:相比吉廷斯指數(Gittins Index)等複雜方法,湯普森採樣僅需簡單的蒙特卡洛採樣即可實現。

進階應用:情境式吃角子老虎機

若問題擴展到情境式吃角子老虎機(Contextual Bandits),湯普森採樣可結合線性模型或神經網路,將情境特徵(如用戶畫像)納入分佈建模。例如,電商平台可用此方法動態調整廣告投放:

- 每個廣告選項視為一台老虎機,用戶點擊率(CTR)為獎勵。

- 根據用戶的歷史行為(情境),模型會預測各廣告的CTR分佈,並透過採樣選擇最佳曝光選項。

常見誤區與修正建議

- 過度探索:新手可能誤解「隨機採樣」等於完全隨機選擇,但實際上湯普森採樣的隨機性是基於當前知識的不確定性,而非盲目嘗試。解決方案是確保分佈參數(α,β)合理初始化。

- 忽略非平穩性:在動態環境中(如用戶偏好變化),需定期重置分佈參數或引入衰減因子,避免舊數據主導決策。

- 與UCB1的混淆:雖然兩者都解決探索與利用問題,但UCB1依賴確定性邊界,湯普森採樣則依賴概率模擬。實務上,後者在小型數據集表現通常更穩定。

工具與框架推薦

2025年主流的機器學習套件(如Python的scikit-learn、Pyro或TensorFlow Probability)均已內建湯普森採樣的實作模組。若需自訂分佈(如處理非伯努利獎勵),可結合NumPy的隨機採樣功能,靈活擴展至高斯分佈或泊松分佈等場景。

透過上述分析可見,湯普森採樣不僅是理論優雅的最優策略,更是實務中解決多臂賭博機問題的利器,尤其適合需要即時反饋與動態調整的應用場景。

關於algorithm的專業插圖

隨機式bandit應用

隨機式bandit應用在2025年的強化學習領域中,仍然是解決探索-利用權衡問題的核心工具之一。這種方法特別適合需要快速決策的場景,例如線上廣告投放、推薦系統或醫療實驗設計。多臂老虎機的本質是透過概率論來模擬不同選擇的獎勵分佈,並在過程中動態調整策略,以最大化長期收益。舉例來說,當一家電商平台需要測試哪種廣告版位最能吸引用戶點擊時,就可以透過隨機式bandit來分配流量,同時避免過度依賴單一版位而錯失其他潛在高報酬的機會。

在實際操作中,隨機式bandit常會搭配UCB1 algorithm或湯普森採樣來平衡探索與利用。UCB1的核心思想是計算每個選項的上置信界,優先選擇置信區間上限最高的選項,這種方法能有效減少累積懊悔。例如,一個遊戲公司想測試新角色技能的效果,可以利用UCB1動態分配測試資源,快速收斂到最佳解。而湯普森採樣則是透過伯努利分佈模擬每個選項的獎勵概率,再根據採樣結果決定下一步行動,這種方法在數據稀疏時特別有用,像是新產品上市前的市場調研。

情境式吃角子老虎機是隨機式bandit的進階應用,它考慮了環境變量對獎勵的影響。例如,在個性化教育平台中,系統會根據學生的學習進度(情境)動態推薦題目,這時就需要結合強化學習來優化最優策略。2025年的技術趨勢顯示,這類應用已從單純的貪婪算法轉向混合模型,例如結合蒙特卡洛採樣來預測長期效益,或引入對抗式多臂賭博機來應對惡意點擊等干擾行為。

對於開發者來說,實作隨機式bandit時需注意以下細節:

1. 獎勵概率分佈的假設是否合理(例如是否真的符合伯努利分佈)。

2. 如何設定探索與利用的權重比例,過度探索會浪費資源,過度利用則可能陷入局部最優。

3. 在動態分配指數計算中加入時間衰減因子,以適應非平穩環境(如用戶偏好的季節性變化)。

以金融業為例,當銀行用bandit模型推薦信用卡方案時,會發現吉廷斯指數這類動態規劃方法比靜態規則更有效,因為它能即時反映市場變化。不過要注意的是,隨機式bandit的效能高度依賴數據驅動的迭代速度——在2025年,領先企業已將模型更新週期縮短到分鐘級,例如透過邊緣計算即時處理用戶反饋。

最後,勘探-開發兩難的解決不該只依賴單一算法。實務上常會採用A/B測試與bandit的混合架構:初期用A/B測試廣泛收集數據,中期切換到UCB1演算法快速收斂,後期再導入情境式吃角子老虎機進行微調。這種分階段策略在電商大促期間尤其重要,能同時兼顧短期的轉化率和長期的用戶體驗優化。

在技術選型方面,2025年的開源生態已出現更多針對多臂賭博機問題的專用庫,例如支援分散式運算的BanditLib 3.0,其內建了對抗噪聲數據的魯棒性處理。這讓工程師能更專注於策略最佳化,而非底層數學實現。不過要提醒的是,隨機式bandit本質仍是期望獎勵的權衡工具,若業務目標包含品牌安全等非量化指標,則需額外設計懲罰機制來約束模型行為。

關於伯努利分佈的專業插圖

UCB1遺憾上界解讀

UCB1遺憾上界解讀:深入分析探索與利用的數學邊界

在強化學習領域中,UCB1 algorithm(上置信界算法)被廣泛應用於解決多臂老虎機問題,其核心思想是透過數學公式平衡探索與利用的權衡。UCB1的獨特之處在於它提供了一個嚴謹的遺憾上界(regret bound),這讓開發者能量化演算法在長期運作中的效能極限。具體來說,UCB1的遺憾上界為O(√(n log n)),其中n代表拉桿次數,這意味著隨著試驗次數增加,累積懊悔(累積懊悔)的增長速度會被有效控制。

UCB1的數學基礎與實作邏輯

UCB1的公式結合了兩大關鍵元素:

1. 期望獎勵的經驗估計(即過往拉桿的平均回報)

2. 探索項(confidence interval),用於調整未充分探索的拉桿權重

公式表達為:

UCB1 = μ̂ᵢ + √(2 ln n / nᵢ) - μ̂ᵢ代表第i根拉桿的當前平均獎勵

- nᵢ是該拉桿被拉動的次數

- n為總試驗次數

這個設計確保了獎勵概率分佈不確定性高的拉桿(例如很少被嘗試的選項)會獲得更高的探索優先權,從而避免貪婪算法可能陷入的局部最優陷阱。

實際案例:伯努利分佈下的UCB1表現

假設一個多臂賭博機有3根拉桿,其真實獎勵概率(伯努利分佈參數)分別為0.3、0.5、0.7。若直接採用貪婪策略,可能會過早鎖定初始回報較高的0.5拉桿,忽略真正最佳的0.7選項。但UCB1會透過動態調整探索項,在前期主動測試0.7拉桿,最終將最優策略收斂至高概率選項。根據2025年最新的機器學習實證研究,UCB1在類似情境中的累積懊悔比純隨機探索減少約40%。

與其他方法的比較:湯普森採樣與吉廷斯指數

相較於湯普森採樣(基於貝氏概率的隨機策略)或吉廷斯指數(適用於無限時域的動態分配指數),UCB1的優勢在於其確定性與理論保證。例如:

- 湯普森採樣依賴蒙特卡洛採樣,計算成本較高,但能更靈活處理非靜態環境

- 吉廷斯指數雖在理論上最優,但實作複雜度高,且假設獎勵分佈需符合嚴苛條件

UCB1則以輕量級計算達成策略最佳化,特別適合數據驅動的即時決策系統,如線上廣告投放或推薦系統的A/B測試。

進階議題:對抗式與情境式變體的挑戰

在對抗式多臂賭博機或情境式吃角子老虎機中,UCB1的原始設計可能需進一步調整。例如:

- 對抗式環境下,對手可能刻意改變獎勵分佈,此時需引入加權機制或滑動窗口來追蹤動態變化

- 情境式問題則需結合特徵提取(如用戶畫像),將UCB1擴展為「情境UCB」以處理多維度輸入

2025年學界提出的改良版UCB1-Tuned,更進一步整合了變異數估計,強化了在非穩定分佈下的魯棒性。這類進化讓UCB1持續成為概率論與強化學習交會點的經典解方。

關鍵操作建議

實務上,使用UCB1時應注意:

- 初期探索次數需足夠,避免因冷啟動導致遺憾上界膨脹

- 監控拉桿的獎勵分佈穩定性,必要時重設計數器nᵢ以適應環境變化

- 在資源有限時,可混合貪婪策略(例如後期固定探索率)以降低計算開銷

透過這些細節優化,UCB1能更精準地駕馭勘探-開發兩難,為多臂吃角子老虎機測試提供兼具理論嚴謹性與實務可行性的解方。

關於勘探-開發兩難的專業插圖

商業決策應用案例

商業決策應用案例:多臂老虎機如何實際驅動企業策略?

在2025年的商業環境中,多臂老虎機問題(Multi-Armed Bandit, MAB)的應用已從學術理論躍升為企業核心工具,尤其適合解決探索-利用權衡(Exploration-Exploitation Dilemma)的難題。舉例來說,電商平台常面臨「該推薦哪款商品給用戶」的決策:若過度聚焦熱銷品(貪婪算法),可能錯失潛力新品;但盲目測試新選項又會降低短期收益。這時,強化學習中的UCB1演算法(上置信界算法)就能動態平衡兩者,透過計算期望獎勵的置信區間,優先選擇「高潛力但尚未充分探索」的選項,最大化長期收益。

具體案例:動態廣告投放的優化

一家跨國零售集團在2025年導入湯普森採樣(Thompson Sampling)來優化數位廣告預算分配。傳統A/B測試需固定分流,導致部分用戶長期接觸次優廣告;而MAB框架則讓系統即時調整獎勵概率分佈(假設點擊率服從伯努利分佈),每小時更新各廣告版的曝光權重。結果顯示,相較於靜態分配,採用情境式吃角子老虎機(Contextual Bandit)的模型將轉換率提升23%,同時減少15%的累積懊悔(Regret)。

製造業的資源分配策略

半導體大廠則運用吉廷斯指數(Gittins Index)解決產線調度問題。當多條生產線(對應MAB中的「手臂」)的良率不確定時,該指數會綜合考量探索與利用:優先投產「當前良率高」的線別,但也保留資源測試新製程。這種數據驅動方法讓設備使用效率提高18%,尤其適合獎勵分佈隨時間變化的場景(如機台老化)。

實務建議:如何選擇合適的MAB演算法?

1. UCB1演算法:適合獎勵分佈穩定的情境(如固定客群的購物行為),其數學保證能收斂到最優策略。

2. 湯普森採樣:當數據稀疏或需快速適應變化時(如短期的促銷活動),其蒙特卡洛採樣特性更能反映不確定性。

3. 對抗式多臂賭博機(Adversarial Bandit):若環境存在惡意干擾(如競爭對手刻意操縱市場),可改用此類魯棒性強的模型。

挑戰與突破

儘管MAB在商業決策成效顯著,2025年企業仍面臨兩大痛點:一是動態分配指數的計算成本(如吉廷斯指數需離線預計算),二是概率論假設與現實的落差(如用戶行為未必符合預設分佈)。最新解法是結合深度學習的情境式吃角子老虎機,能從非結構化數據(如社群輿情)提取特徵,動態調整策略最佳化路徑。例如,某金融科技公司藉此將貸款審核的「誤拒率」降低30%,同時維持風險控管水準。

關鍵啟示

企業導入MAB時,需明確定義「獎勵」(如點擊率、營收、良率)並監控累積懊悔指標。若過早收斂到局部最優解(例如僅推廣少數爆品),可能需手動注入探索因子。2025年的領先企業已將MAB與強化學習整合,打造閉環決策系統,從多臂吃角子老虎機測試中持續迭代,真正實現「邊賺邊學」(Learn-as-You-Earn)的商業智慧。

🌟 1win 娛樂平台

500% 獎金 | 12000+ 遊戲 | 加密貨幣即時出款

關於吃角子老虎機問題的專業插圖

Python實作教學

在強化學習領域中,多臂老虎機問題(Multi-armed Bandit Problem)是一個經典的探索-利用權衡(Exploration-Exploitation Tradeoff)範例,而用Python實作這些演算法不僅能幫助理解核心概念,還能實際應用在推薦系統或A/B測試等場景。以下我們就來深入探討幾種主流演算法的Python實作方法,並附上具體程式碼範例與分析:

首先,我們需要模擬一個多臂賭博機環境。假設有5台吃角子老虎機(對應5個選項),每台的獎勵概率分佈服從伯努利分佈(Bernoulli Distribution),也就是成功概率(p)各不相同。用Python的numpy可以輕鬆生成模擬數據:

importnumpyasnptrue_probs=[0.3,0.5,0.7,0.4,0.6]n_bandits=len(true_probs)defpull_arm(arm_idx):# 根據伯努利分佈回傳1(成功)或0(失敗)returnnp.random.binomial(1,true_probs[arm_idx])這個環境會是後續測試UCB1 algorithm、湯普森採樣(Thompson Sampling)等策略的基礎。

最簡單的策略是貪婪算法,也就是每次都選擇當前期望獎勵最高的選項。但這種方法容易陷入局部最優,忽略勘探-開發兩難中的探索價值:

classGreedyBandit:def__init__(self,n_arms):self.n_arms=n_armsself.counts=np.zeros(n_arms)# 各臂拉動次數self.values=np.zeros(n_arms)# 各臂平均獎勵defupdate(self,arm_idx,reward):self.counts[arm_idx]+=1n=self.counts[arm_idx]self.values[arm_idx]=((n-1)*self.values[arm_idx]+reward)/ndefselect_arm(self):returnnp.argmax(self.values)# 直接選擇當前最佳實測時會發現,如果初始估計偏差較大(例如第一台老虎機初始獎勵高但實際p值低),貪婪策略可能永遠不會探索其他更優選項。

為解決貪婪算法的缺陷,UCB1演算法引入了不確定性的量化,平衡探索與利用。其核心公式是: [ \text{UCB}(t) = \hat{\mu}_i + \sqrt{\frac{2 \ln t}{n_i}} ] 其中,(\hat{\mu}_i)是平均獎勵,(t)是總次數,(n_i)是第(i)臂的拉動次數。Python實作如下:

classUCBBandit:def__init__(self,n_arms):self.n_arms=n_armsself.counts=np.zeros(n_arms)self.values=np.zeros(n_arms)defupdate(self,arm_idx,reward):self.counts[arm_idx]+=1n=self.counts[arm_idx]self.values[arm_idx]=((n-1)*self.values[arm_idx]+reward)/ndefselect_arm(self):total_counts=np.sum(self.counts)ucb_values=self.values+np.sqrt(2*np.log(total_counts)/(self.counts+1e-5))returnnp.argmax(ucb_values)UCB1的優勢在於其理論保證(累積懊悔成長率為對數級),但需注意在早期階段可能過度探索。

另一種基於貝葉斯思想的策略是湯普森採樣,它通過對獎勵概率分佈進行採樣來動態調整選擇。假設獎勵服從伯努利分佈,我們可以用Beta分佈作為共軛先驗:

classThompsonBandit:def__init__(self,n_arms):self.n_arms=n_armsself.alpha=np.ones(n_arms)# Beta分佈參數α(成功次數)self.beta=np.ones(n_arms)# Beta分佈參數β(失敗次數)defupdate(self,arm_idx,reward):self.alpha[arm_idx]+=rewardself.beta[arm_idx]+=(1-reward)defselect_arm(self):sampled_probs=np.random.beta(self.alpha,self.beta)returnnp.argmax(sampled_probs)湯普森採樣在實務中表現優異,尤其適合情境式吃角子老虎機(Contextual Bandits),且計算效率高於UCB1。

如果面對對抗式多臂賭博機(Adversarial Bandits),即獎勵概率被人為操縱或隨時間變化,傳統方法可能失效。此時可考慮EXP3算法,它通過指數加權來適應對抗性環境:

classEXP3Bandit:def__init__(self,n_arms,gamma=0.1):self.n_arms=n_armsself.gamma=gammaself.weights=np.ones(n_arms)self.probs=np.ones(n_arms)/n_armsdefselect_arm(self):self.probs=(1-self.gamma)*self.weights/np.sum(self.weights)+self.gamma/self.n_armsreturnnp.random.choice(self.n_arms,p=self.probs)defupdate(self,arm_idx,reward):estimated_reward=reward/self.probs[arm_idx]self.weights[arm_idx]*=np.exp(self.gamma*estimated_reward/self.n_arms)此類演算法更注重策略最佳化,適合動態變化的商業場景(如線上廣告競價)。

最後,我們可以用累積懊悔(Cumulative Regret)來比較不同演算法的表現。懊悔定義為最優策略的理論獎勵與實際獲得獎勵的差值:

defsimulate(bandit,n_steps=1000):regret=[]optimal_prob=max(true_probs)total_reward=0fortinrange(n_steps):arm=bandit.select_arm()reward=pull_arm(arm)bandit.update(arm,reward)total_reward+=rewardregret.append(optimal_prob*(t+1)-total_reward)returnregret透過繪製懊悔曲線(如Matplotlib),可直觀觀察到UCB1和湯普森採樣如何快速收斂,而貪婪算法可能長期陷於高懊悔區域。

關於對抗式多臂賭博機的專業插圖

2025最新研究趨勢

2025年多臂老虎機問題的最新研究趨勢可以說是百花齊放,尤其是在強化學習和探索-利用權衡的領域有了重大突破。今年最受矚目的發展莫過於結合湯普森採樣與深度神經網絡的混合模型,這種方法不僅能更精準預測獎勵概率分佈,還能動態調整探索與開發的比例。舉個實際例子,Google DeepMind在2025年初發表的研究就顯示,他們的改良版UCB1演算法在處理對抗式多臂賭博機時,累積懊悔降低了將近40%,這對於像線上廣告投放這類需要即時決策的應用來說簡直是game changer。

另一個值得注意的趨勢是情境式吃角子老虎機的興起。傳統的多臂賭博機問題假設每個arm的回報是固定的,但現實中很多情況(比如推薦系統)會受到用戶特徵等情境因素影響。2025年的新研究開始大量採用概率論框架來建模這些複雜情境,像是MIT團隊就開發出一個基於伯努利分佈的變體模型,能根據用戶畫像動態調整期望獎勵的計算方式。這種方法特別適合電商平台的個性化推薦,實驗數據顯示轉化率能提升25%以上。

在演算法優化方面,吉廷斯指數的應用範圍在2025年有了顯著擴展。傳統上這個指數主要用於無限時域問題,但最新研究成功將其改良為適用於有限時域的版本,並結合蒙特卡洛採樣來提高計算效率。例如,Amazon的物流團隊就運用這個改良版指數來優化倉庫機器人的路徑規劃,讓最優策略的計算時間從原本的幾小時縮短到幾分鐘。這類進展顯示多臂吃角子老虎機測試已經從純粹的學術研究邁向實際商業應用。

關於探索-開發兩難的理論突破也是2025年的亮點。Stanford大學的研究團隊提出了一個全新的框架,將貪婪算法和隨機探索的優點結合起來。他們發現,在某些特定條件下(比如獎勵分佈呈現長尾特性時),適度增加隨機探索的比例反而能提高整體回報。這個發現挑戰了過去一味追求策略最佳化的傳統思維,為上置信界算法的改進提供了新方向。實際測試中,這套框架在醫療資源分配等敏感領域表現特別出色。

最後不能不提的是數據驅動方法在2025年的爆炸性成長。隨著邊緣計算設備的普及,研究人員現在能收集到更細膩的即時反饋數據。這讓動態分配指數的調整變得更加靈活,也催生了一批新的機器學習模型。比如台灣的AI新創就開發出一套能自我演化的多臂老虎機系統,它會根據用戶行為不斷微調獎勵分佈的參數,在金融科技領域的A/B測試中展現出驚人的適應能力。這種融合了線上學習和傳統賭博機理論的做法,很可能會成為未來幾年的主流研究方向。

關於情境式吃角子老虎機的專業插圖

算法效能比較表

在多臂老虎機問題的實務應用中,選擇合適的算法直接影響累積懊悔(Regret)和期望獎勵的表現。以下是2025年常見算法的效能比較表與深度分析,幫助你理解不同策略如何應對探索-利用權衡(Exploration-Exploitation Tradeoff)的挑戰:

UCB1演算法(上置信界算法)

透過數學公式平衡探索與利用,在伯努利分佈的獎勵環境下表現穩定。優點是無需預設參數,但缺點是早期階段可能過度探索,導致初期懊悔較高。2025年最新研究顯示,UCB1在對抗式多臂賭博機情境中,若對手動態調整獎勵分佈,其效能會顯著下降。湯普森採樣(Thompson Sampling)

基於貝氏概率動態更新獎勵概率分佈,適合數據驅動的場景。實測中,它在情境式吃角子老虎機(Contextual Bandit)的表現優於UCB1,尤其當獎勵分佈非靜態時。例如,在醫療實驗的動態分配中,湯普森採樣能快速收斂至最優策略。貪婪算法(Greedy Algorithm)

單純選擇當前最高期望獎勵的選項,忽略探索。雖然計算效率高,但在概率論中已被證明容易陷入局部最優。2025年業界多用於初步測試,或結合ε-greedy策略(例如動態調整ε值)來平衡風險。吉廷斯指數(Gittins Index)

理論上能解決勘探-開發兩難,但計算複雜度高,僅適用於有限狀態的多臂賭博機問題。2025年已有改良版結合蒙特卡洛採樣,降低運算成本,適合金融領域的高頻決策。對抗式算法(Adversarial Bandit Algorithms)

當獎勵分佈被惡意操控時(如網路安全攻防),傳統基於獎勵概率分佈的假設失效。此類算法透過「權重調整」動態適應,但需犧牲部分累積獎勵來換取穩健性。

以下為簡化後的比較表(基於2025年常見測試環境):

| 算法 | 最佳情境 | 優勢 | 劣勢 |

|---|---|---|---|

| UCB1 | 靜態獎勵分佈 | 理論保證、無參數調優 | 初期懊悔高、對抗性差 |

| 湯普森採樣 | 動態或情境式環境 | 適應快、貝氏推斷直觀 | 需預設先驗分佈 |

| 貪婪+ε調參 | 資源有限的快速決策 | 低計算成本 | 需手動調參、易過早收斂 |

| 吉廷斯指數 | 小規模狀態空間 | 理論最優解 | 計算複雜度高 |

- 數據特性:若獎勵分佈符合伯努利分佈,UCB1或湯普森採樣更可靠;非平穩環境則需動態策略。

- 運算資源:吉廷斯指數需要大量資源,而貪婪算法適合邊緣設備(如IoT裝置)。

- 懊悔容忍度:醫療或金融領域可能無法承受初期高懊悔,此時湯普森採樣的穩定性更重要。

舉例來說,2025年某電商平台使用多臂吃角子老虎機測試推薦廣告版位,發現混合策略(UCB1初期探索 + 湯普森後期優化)能降低30%的累積懊悔。這顯示策略最佳化需結合場景需求,而非單一算法主導。

關於概率論的專業插圖

實戰演練步驟

實戰演練步驟

要解決多臂老虎機問題,光懂理論是不夠的,關鍵在於如何將強化學習演算法實際應用在數據上。以下是2025年最新的實戰步驟,幫助你高效處理探索-利用權衡(Exploration-Exploitation Tradeoff),並最大化期望獎勵。

首先,明確你的目標:假設你在測試一個廣告投放系統,每條廣告對應一個「手臂」,點擊率(CTR)就是獎勵分佈。這裡適合用伯努利分佈模擬二元的成功/失敗結果(例如點擊=1、未點擊=0)。接著設定:

- 手臂數量(例如5種廣告版本)

- 每個手臂的真實獎勵概率(未知,需通過實驗估計)

- 總試驗次數(如1,000次曝光)

根據問題特性挑選策略:

- UCB1演算法(上置信界算法):適合需快速收斂的場景,直接計算「平均值 + 探索項」來平衡探索與利用。

- 湯普森採樣:利用貝葉斯概率動態更新信念,特別適合非靜態環境(如用戶偏好隨時間變化)。

- 貪婪算法(純開發):作為基準對照,但容易陷入局部最優。

初始化時,為每個手臂分配少量試行(例如各10次),避免冷啟動偏差。

每次試驗的流程:

1. 選擇手臂:根據當前策略選出最高潛力的選項(如UCB1的置信上限或湯普森的隨機採樣)。

2. 觀察獎勵:記錄結果(如用戶是否點擊)。

3. 更新模型:調整該手臂的獎勵概率分佈(例如更新Beta分佈的α/β參數)。

實際範例:

若廣告A在100次曝光中有20次點擊,其點擊率估計為20%,但UCB1會加上一個探索項(如√(2lnN/n),N=總次數、n=當前次數),讓新手臂有機會被選中。

關鍵指標包括:

- 累積懊悔(Regret):與最優手臂的獎勵差距,越低越好。

- 收斂速度:演算法多快鎖定最佳手臂。

若發現貪婪算法表現差,可能是勘探-開發兩難未解決,這時需增加探索(例如ε-greedy設定10%隨機探索)。進階調整可結合情境式吃角子老虎機(Contextual Bandit),加入用戶特徵提升精準度。

- 非靜態環境處理:當獎勵概率隨時間變化(如廣告疲勞),可引入滑動窗口或折扣因子,讓舊數據影響力下降。

- 對抗式多臂賭博機:若競爭對手刻意干擾(如惡意點擊),改用魯棒性強的演算法如EXP3。

- 蒙特卡洛採樣:在複雜分佈下,用模擬方法近似吉廷斯指數等動態分配策略。

常見錯誤:

- 忽略冷啟動問題,導致初期探索不足。

- 過度依賴單一演算法,未比對多種策略(如UCB1 vs 湯普森)。

- 未監控累積懊悔,誤判收斂效果。

透過這些步驟,你能系統化解決多臂吃角子老虎機測試,並在實際應用中(如推薦系統、A/B測試)找到最優策略。記住,數據驅動的迭代才是關鍵!